Le 29 février 2009, Google abandonne la marque déposée TrustRank, mais vient de déposer un brevet le 13 octobre 2009 qui s’intitule « Search Result Ranking Based On Trust ».

Le 29 février 2009, Google abandonne la marque déposée TrustRank, mais vient de déposer un brevet le 13 octobre 2009 qui s’intitule « Search Result Ranking Based On Trust ».

Cette nouvelle notion s’éloigne encore plus du mythe véhiculé sur Internet à propos d’un TrustRank pour les sites de confiance. Soudain, nous sommes en face de la réalité d’un PersonRank qui évalue le profil d’un utilisateur et prend en compte ses annotations à propos des pages Web.

C’est en lisant l’article de l’excellent Bill Slawski que je prends connaissance de ce nouveau développement, mais tout d’abord un bref état des lieux s’impose pour poser des bases saines à propos du TrustRank.

Comme j’expliquais il y a peu dans mon article sur le mythe du TrustRank, la plupart des gens font référence à cette notion par rapport à une étude qui n’a rien à voir avec Google puisqu’elle est associée avec Yahoo!. Par ailleurs, Matt Cutts confirmait que le TrustRank était seulement un filtre antiphising qui n’était pas lié à l’étude en question. Explication par l’intéressé dans la vidéo suivante.

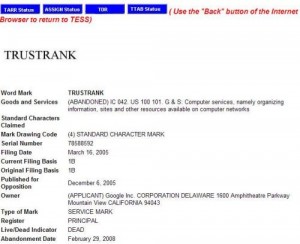

Abandon de la marque TrustRank

Le 29 février 2009, Google abandonne le dépôt de marque TrustRank comme démontre l’aperçu de gauche, mais un dépôt de brevet au 13 octobre 2009 indique une évolution intéressante pour la recherche d’information, tout en s’éloignant encore plus du mythe qui reste bien profondément marqué chez les webmasters et référenceurs.

Le 29 février 2009, Google abandonne le dépôt de marque TrustRank comme démontre l’aperçu de gauche, mais un dépôt de brevet au 13 octobre 2009 indique une évolution intéressante pour la recherche d’information, tout en s’éloignant encore plus du mythe qui reste bien profondément marqué chez les webmasters et référenceurs.

Google met au point un système innovant de classement des pages qui prend en compte les annotations des utilisateurs en tant que vote de confiance. Bien entendu, on pense tout de suite à SideWiki qui vient d’être lancé et qui permet effectivement de poser des commentaires à propos d’une page Web. Ce qui est intriguant est qu’il n’y a pas de référence à Sidewiki dans le brevet déposé par Google, mais par contre Slawski note une ressemblance avec l’étude élaborée par l’ingénieur Google, Ramanathan Guha, alors qu’il était chez IBM. Puisque c »est Guah qui a déposé le brevet au nom de Google, il est clair que son travail actuel est une prolongation du travail effectué chez IBM dont l’étude en question peut nous indiquer des pistes pour mieux comprendre ce qui se trame chez Google.

Le brevet du Trust Rank

Search result ranking based on trust

Invented by Ramanathan Guha

Assigned to Google

US Patent 7,603,350

Granted October 13, 2009

Filed: May 9, 2006

L’extrait du brevet se traduit comme suit :

Un moteur de recherche procure des résultats qui sont classés en fonction d’une mesure de confiance associée avec des entités présentées sous forme de notes au sein des résultats de recherche. Un moteur de recherche reçoit une requête et sélectionne les documents pertinents pour cette requête.

Le moteur de recherche détermine également les notes associées avec les documents sélectionnés, ainsi que les niveaux de confiance des entités qui procurent les notes. Les niveaux de confiance sont utilisés pour déterminer le facteur de confiance des documents respectifs. Les facteurs de confiance sont également utilisés pour ajuster le score de récupération de l’information des documents. Les résultats de recherche sont ainsi classés sur la base d’information du score ajusté.

C’est donc la notion de pertinence des notes posées par des utilisateurs qualifiés qui ressort. Le challenge consiste à récupérer et analyser ces notes, mais surtout de cerner qui sont les utilisateurs dont les commentaires portent un certain poids.

Au-delà de SideWiki, il est possible d’annoter des pages lorsque nous sommes connectés à notre compte Google, ainsi que les discussions Google Wave, mais il existe également de nombreux supports possibles pour dénicher des notes d’utilisateurs. Pour cela, il faut que Google sorte de son carcan pour explorer les commentaires de blogs, discussions Wiki, etc.

Mais d’abord, il faut s’attacher à savoir comment cerner le profil d’un internaute…

Évaluer l’utilisateur humain, le PersonRank

Recentrer le classement des résultats de recherche autour de l’utilisateur a toujours été quelque chose que je défends. Selon moi, Google n’a pas attendu ce brevet pour évaluer le profil d’un utilisateur et s’en servir pour mieux classer les pages. L’élément clef pour agir de la sorte est la Google Toolbar qui détermine facilement un profil d’internaute puisqu’elle analyse la navigation et l’utilisation des pages Web. Maintenant, grâce à d’autres supports comme SideWiki et Google Wave, le moteur de recherche dispose en interne de puissants outils pour évaluer encore plus précisément le profil d’un internaute.

Ainsi, pendant que les webmasters focalisaient sur le PageRank, vote d’une page Web vers une autre, Google travaillait pour recentrer sa manière de classement sur le vote de l’internaute. C’est d’ailleurs assez fascinant d’observer les implications du partenariat avec Twitter, notamment pour mieux cerner le Web sémantique.

La prochaine rumeur qui va parcourir le milieu du référencement sera le PersonRank. Vous voulez qu’on lance un buzz ?

Halte au mythe du TrustRank. Vive le nouveau mythe du PersonRank

La légende urbaine du TrustRank semble bien établie au sein de la communauté du référencement et au-delà. Pour les croyants en ce mythe, Google applique un classement en fonction du niveau d’autorité du site et conséquemment sur le vote qu’il va envoyer au travers d’un lien (backlink). Cette notion existe évidemment dans l’algo, mais ce n’est pas du tout lié au TrustRank comme expliqué précédemment et ce nouveau développement nous éloigne encore plus de ce fantasme à moitié abouti.

Il existe bien un Trust Rank ou classement de confiance, mais il est centré autour de l’internaute ( PersonRank ), plutôt que sur les sites Web. C’est d’ailleurs logique puisque Google est toujours aussi incapable de combattre efficacement le spam. Se tourner vers la pertinence du vote humain est bien plus fiable que laisser l’algorithme s’embourber avec ce classement des pages Web qui reste perfectible.

Je ne crois pas que Google trafique manuellement les résultats de recherche. Les suspicions liées à un déclassement des résultats naturels après avoir arrêté de payer des liens sponsorisés Adwords ne tient pas debout et n’a jamais été formellement prouvé. Mis à part le blacklistage d’un site qui est effectué manuellement, c’est bien sur une base d’algorithmes par couches que le moteur fonctionne. La subtilité actuelle consiste à récupérer un élément humain (vote de confiance) pour l’intégrer dans ce classement automatique.

Google souhaite rendre ses résultats de recherche meilleurs grâce au vote de confiance par l’utilisateur qualifié. Nous entrons dans l’ère du Social Media Optimization (SMO) avec un enjeu majeur pour les sociétés qui peinent véritablement à trouver la manière de pénétrer le Web communautaire. Seulement, le partenariat annoncé avec Twitter marque évidemment une démarche dans ce sens, mais je ne sais pas si l’outil de micro-blogging est vraiment le bon choix pour améliorer la pertinence.

Pour terminer, certains sont outrés de ma réaction par rapport au rejet de Google Wave, mais il faut comprendre que je sais depuis longtemps que Google a enregistré mon profil en tant qu’utilisateur et certainement aussi en tant que référenceur. On joue sur une tendance dangereuse car je suis jugé par un moteur de recherche et toute ma vie en ligne peut être impactée par cette évaluation. Chaque outil Google que j’utilise entre des données sur mon profil et il n’y a pas besoin d’être paranoïaque pour comprendre que c’est un sentiment extrêmement désagréable d’avoir un PersonRank, surtout qu’il est impossible d’y échapper. Il ne faut pas oublier que le rêve de Larry Page, fondateur de Google, est d’implanter une puce dans notre cerveau qui permettrait de penser à une requête et d’obtenir instantanément la réponse sur son mobile. Depuis que Page a émis cette idée, les ingénieurs Google ont entendu le message, mais bien extrapolé!

Pour sur, le Trustrank tel qu’il est présenté sur beaucoup de blogs est une illusion. Il est clair que Google a beaucoup plus d’intéret à considérer les choix des internautes pour la pertinence de ses résultats. Le web 2.0 en quelque sorte, c’est l’internaute qui « travaille ».

le buzz est lancé 😉

Si l’intérêt du Person Rank comme tu l’appelles est certain. Qui mieux qu’un humain peut vérifier la ohérence d’un site par rapport à une recherche…Reste des questions en suspens? Quelle modélisation, comment mettre en pratique le Person Rank qui à mon avis est plus manipulable encore que le page rank….

Une autre manière d’intégrer l’humain dans la recherche est d’utiliser les commentaires que les utilisateurs peuvent laisser sur les Google Maps.

A terme, il va devenir quasiment impossible pour les B2B de se positionner sur des requêtes compétitives et le recours à l’achat de pub sur les blogs, les médias sociaux et bien sur Adwords, deviendra la seule option.

Sympa tout de même la base de données de Google… Ca devient aussi énorme que Facebook, sans formulaire à remplir…

Cela rejoint pas mal ce que disait Aurélien Bardon sur le fait que Google pistait et profilait les SEO.

Pour ma part, si j’additionne Gmail + Chrome + Wave + Analytics, c’est bon, Google connaît ma vie personnelle et professionnelle.

Quel serait alors le poids d’un votre venant d’un profil SEO passionné par les boomerangs ( 😛 ) sur une requête spécifique aux boomerangs ou à l’Australie ?

Si les résultats de recherche vont être plus pertinents pour la masse, j’ai peur qu’ils le soient moins pour les autres, je trouve qu’on commence à payer cher nos données personnelles…

Et ces résultats, seront-ils rankés selon notre profil aussi ? Si c’est le cas, on se rapproche petit à petit de la matrice 😀

Ca donne d’autres pistes pour adapter notre travail, mais l’effet pervers ne sera-t-il pas l’apparition de petites armées de voteurs qualifiés payés au lance pierre et chargés de faire monter les sites des gros poissons ?

J’avais déjà émis le doute on my blog sur le fait que les données accumulées par Google de chaque internaute loggé sur un de leur compte, genre historique et preferred sites auront un impact SEO dans le futur (si ce n’est déjà fait) :s

On se rejoint sur le trustrank, même si je pense que les référenceurs ont avant tout repris au compte de Google, un mot qui servait à appliquer une notion d’autorité d’un site.

Concernant le « personrank » (joli nom) ce principe va totalement dans le sens d’un combat féroce contre le spam pour lequel, comme tu le dis très justement, Google s’embourbe quotidiennement. Il suffit de jeter un coup d’oeil au classement du concours black hattitude pour s’en convaincre.

A terme, je ne pense pas que le principe d’un personrank soit si manipulable que cela contrairement à ce que dit Léo. Si le concept repose sur l’internaute, son utilisation et la consultation des sites (durée, pages visitées, messages adressés à des proches, etc.) les sites offrant un contenu pertinent et intéressant devraient tirer leur épingle du jeu au détriment des sites spamy.

Comme tu le fait très judicieusement remarquer au sujet de Google Wave, Google possède aujourd’hui une telle baterie de services qu’il lui est facile de tirer partie des montagnes d’informations et de les corréler pour attribuer une note de pertinence à un site. Cette note de pertinence étant réalisée par rapport à une utilisation que l’internaute a eu du site, bien plus qu’à son nombre de BL.

Peut-être un retour au « content is king » sur le fond, car un site qui plait fait parler de lui en bien et bénéficie naturellement d’un « bruit » positif, le concept de « personrank » lui sera très favorable.

Pour la puce dans le cerveau, ils ne m’aurons pas, je suis le n° 6bis 😉

J’évite analytics, je n’utilise quasiment jamais Gmail, je n’utilse pas blogger, etc.

@AxeNet je pense que tu voulais dire Mathieu 🙂

@ Leo, non je voulais dire « Paris sportif », désolé 🙁

Tu m’excuseras.

Le référencement change de jour en jour, avant c’était la course au pagerank, aux BL, etc. Maintenant pour mieux se référencer faudra faire plus de qualité et c’est tant mieux.

@agence web : la confusion sur le TrustRank est une méprise plutôt qu’une illusion.

@paris sportif : manipuler est toujours possible, mais simuler un profil humain n’est pas aussi aisé qu’augmenter artificiellement la notoriété d’un site. Cependant, c’est tout à fait jouable jusqu’à un certain niveau. J’ai déjà quelques petites idées en tête…

@Léo : ah oui, Google Maps est aussi une source de données supplémentaire. En fait, il serait plus rapide de faire le tour des outils et services Google qui ne permettent pas d’entasser des données plutôt que l’inverse.

Tu as lâché le terme magique « pub »! Il ne faut pas oublier que la finalité de Google est bien de gagner du fric. Ce n’est pas par amour des internautes qu’ils nous proposent des outils gratuits. Rien n’est gratuit.. jamais !

Mathieu : ça fait quelques années que Turulilo nous avait communiqué des infos en provenance de Google concernant le principe d' »odeur » rattachée à ton profil d’internaute chez Google. En tant que passionné de boomerang, lorsque tu vas visiter un site de boomerang, tu laisses un certain type d’odeur, puis si tu visites un site sur les chats, tu vas laisser une odeur, mais différemment.

@SEO Sniper : comme j’indique dans l’article, ça remonte même avant l’arrivée des comptes Google. Grâce à la Toolbar, Google est capable de capter des tonnes d’informations utiles. La navigation bien sûr, mais pourquoi pas la mise en favoris d’un site. Quel puissant vote de confiance qu’une mise en favoris! Pareil pour l’abonnement à un flux RSS.

@AxeNet : ça va plus loin que l’utilisation d’un terme à tort. Tout le monde s’est précipité sur l’étude de Pedersen, Molina et Gyöngyi. Je rappelle que ce papier est en relation avec Yahoo! C’est un peu tiré par les cheveux d’en faire une analyse de l’algo Google.

@AQC : le dicton du référenceur « tout ce que je sais est que je ne sais rien »

Je n’avais jamais pensé à tout ça, je suis peut être trop naïf… mais en lisant ton article, c’est vrai que ça fait réfléchir.

Dieu Google connait tout de nous… et ça fait peur.

@axenet: D’un autre coté, tout va dépendre du domaine, un site comme une agence immobilière, fera beaucoup moins parler de lui qu’un blog, ecommerce ou autre activité aimant à backlink et commentaire (positif ou négatif)

Difficile d’avoir un personrank pertinent quand même, tant il est difficile de juger de la pertinence d’un vote (c’est son propre site ? Un site ami ? Il a été payé pour voter ? C’est spontané ? etc…)

Il y a quand même une grosse différence entre recommander à une communauté et prendre cette recommandation comme un gage de pertinence à mon sens (ça fait beaucoup de « pertinent » dans mon commentaire là non ?).

@ Djohan

Ce que tu dis est très juste.

Pour reprendre les cas précis que tu mentionnes, tous les sites d’agences immobilières auront cet handicap. Google pourra donc faire une moyenne de référence parmi les sites de cette thématique. Ils ne seront pas en concurrence avec les blogs traitant du référencement (par exemple).

Restera aux agences « intelligentes » à savoir faire du « bruit » sur le net au sujet de leurs services, prestations, ou dieu sait quoi susceptible de faire parler d’elles.

Même punition pour toutes les thématiques existantes et tous les sites s’y rapportant.

Qu’en penses tu ?

@ Nico

Pour ma part, je ne percevais pas cela comme un vote physique, mais un vote virtuel.

Exemple : J’ai envoyé un mail par Gmail à un ami. Ce mail contient les mots « super, génial, pas cher, excellent service, « produit machin » délais respecté, produit fabuleux, etc. ».

Au milieu de cette orgie de compliments, l’adresse d’un site e-commerce.

Si cette situation est multipliée et corrélée par d’autres (message twitter, Wave, commentaires sur comparateur de prix, et toute la pelletée de services Google que GG pourra décortiquer à loisir, Google pourrait alors tirer parti de ces informations pour impacter la « valeur » d’un site dans une thématique. Voila ce que j’entends par « vote virtuel ».

Oui sylvain, tout à fait d’accord avec ta remarque 😉

Finalement, le référencement laisserait une bonne place au marketing… Mais à contrario, cela ouvrirait encore plus les portes aux spam d’envoi de mail, de twitt etc pour promouvoir un service/site. Je pense même que cela empirerait et saturerait prématurément certains réseaux.

@Laurent: C’est bien de cela que je parle… En quoi sera-ce donc qualifié de ma part…

La propension à naviguer sur les sites à thématique proche ?

La propension à participer à des conversations sur ces thématiques ?

Mais la question que je me pose est : si je suis fiché comme un SEO, quelque soit la thématique du site visité/plébiscité, mon vote sera-t-il considéré au même titre qu’un utilisateur X ?

C’est la manière d’établir ce profil, basé sur les ressources que Google propose, qui me chiffonne…

Et la seconde chose qui me chiffonne, c’est que le visiteur, une fois de plus travail pour Google « gratuitement », et que Google devient, même pour l’utilisateur lambda, beaucoup plus addictif puisque les résultats sont d’autant plus pertinents….

Il va falloir des ressources conséquentes pour lancer un nouveau site maintenant… Les problèmatiques pour un site e-commerce semblent maintenant d’un autre ordre, et il devient évident que son succès ne pourra pas échapper à un passage par AdWords…

Les blogs rapportent de l’argent à Google via AdSense, les sites e-commerce via AdWords… On ne peut plus échapper à Google…. ou plutôt Google ne veut plus qu’on lui échappe !

Une réflexion dans le même esprit :

Quelle intégration du contenu de Twitter et Facebook dans les moteurs de recherches suites aux récents accords ? : http://site-communautaire.blogspot.com/2009/10/quelle-integration-du-contenu-de.html

@Mouky : pour l’utilisateur lambda, c’est indolore, mais ceux qui trempent dans l’algo 24/24 ont tort de ne pas se poser certaines questions. Je reviens sur la ruée vers Google Wave car c’est un bon exemple de la manière dont tout le troupeau ne comprend pas bien ce que je suis en train d’expliquer dans cet article. Ou alors ils s’en foutent (ce qui est encore plus grave).

@Djolhan : c’est clair et net que la pub (Adwords) sera la seule issue pour ceux qui ne seront pas capables de pondre du contenu de grande qualité.

@Nico : selon moi, ça fait déjà depuis 2002 ou 2003 qu’ils bossent sur la question. C’est déjà bien goupillé et déployé !

@AxeNet : ton explication est limpide. Maintenant, faut juste voir comment on va pouvoir le niquer 🙂

@Mathieu : je ne sais pas si « meilleur » est le terme approprié. C’est sûr que l’empreinte sera différente suivant la corrélation entre ton profil et le site visité. Ne te tracasse pas outre mesure. Les fondamentaux restent les mêmes. Nous ne parlons pas d’une élimination complète des paramètres 100% mathématiques remplacés par l’intégration du facteur humain. Puis quoi qu’il arrive, Google reste un idiot incapable de comprendre le sens d’une page. La sémantique appliquée à la recherche d’information reste LE grand challenge. Le real time update et le trust rank sont uniquement des paramètres secondaires.

Les différentes évolutions de l’algorithme de Google et les nouveaux services apportés par Google au fil du temps et surtout récemment (de l’historique du compte Google au SideWiki en passant par le l’accord avec Twitter), tendent bien à prouver que la notion de réseau social et de « relation humaine » prennent le pas sur le référencement « traditionnel ». Ce dernier reste une base (indispensable ?) qui se doit (ou devra) d’être associé avec cette notion de PersonRank (ou SocialRank, c’est pas mal aussi comme terme, non ?). A suivre…

« Prendre le pas » est peut-être exagéré. Je dirais plutôt que c’est une extension des fondamentaux du référencement. Ce n’est pas comme si le Search allait tout remettre à plat avec cette augmentation de la valeur humaine.

Une chose est sûre, le nofollow et le social media ont décapité le référencement organique tel que nous le connaissions. Faut juste se décarcasser un peu plus pour arriver à ses fins, mais le travail reste fondamentalement le même. A cela s’ajoute maintenant d’autres éléments qu’il faut intégrer dans le process.

@Laurent:

😆 je ne suis pas inquiet ! 😀

Je suis certain de m’adapter facilement à ces changements 😉

Ma vision des choses est que ce paramètre « humain » confirmera ou infirmera des positions dans les SERPs.

M’en vais potasser le problème, mais je pense qu’il faudra tout de même davantage de travail pour les sites de niches concurrentielles.

Le spam de goret sur les casinos en ligne devrait être plus difficile 😀

@ Laurent

Suite à ta réponse, deux approches :

– Le « niquer » : C’est un peu l’éternelle histoire entre les cambrioleurs et les fabricants de portes blindées. Donc il y aura toujours des failles. Aux référenceurs de les identifier et de les exploiter. On est dans le grey ou black hat.

– Faire la pu-e » : on rentre dans le rang, on travaille avec le client sur les nécessités d’un marketing et d’une communication globale sur le net, on produit du contenu, on satisfait l’internaute, Google a ses résultats pertinents et de qualité, il est content, et nous aussi. Bien sûr, il faut toujours s’assurer de ne pas venir boire dans son écuelle à dollars car il n’aime pas ça du tout. En même temps, si j’étais à sa place…

La 2ème solution est moins rapide, nécessite bien plus de remise en question de la part du client, met les « pauvres » de coté. Elle est sans doute plus durable dans le temps si les moyens suivent.

Je pense que l’époque de la présence pas chère sur le net est révolue de toute façon.

En résumant, rien ne change sur les principes. Ce sont juste les champs de bataille qui vont changer de relief et les armes être adaptées ou modifiées par nécessité.

Bref, nous aurons de quoi nous occuper pendant les prochaines années.

Une excellente nouvelle pour nous les community managers et autres acteurs du web2 qui créons du contenu de qualité et qui est censé être vu, apprécié et relayé…

Je nage en plein bonheur.

Comment ça perd son rank, on le sait que le PR a disparu!

Désolé, elle était tellement facile…

Plus sérieusement, je lis que le contenu va redevenir roi, qu’on va nous tracer à travers les services de Google…

Mais le classement va t’il repartir de 0? Comment commencer? Certains critères « humains » vont peut-être s’ajouter, voire sûrement, mais les critères actuels ne vont pas disparaitre par magie.

Et si on n’utilise pas gmail, analytics & co, on n’apparaitra pas sur le moteur?

Il ne faut pas chasser un mythe par un autre.

@ Mathieu : ce que je veux dire est qu’on ne dérange pas la matrice d’un algo comme cela. Imagine changer une simple virgule dans une formule mathématique. En plus, il s’agit d’un algo par couches. Pas de souci; la base va rester la même et je ne prédis pas de bouleversements immenses dans les SERPS. Plutôt un « nettoyage ». Si ton site est référencé sur des bases solides, il n’y a rien à craindre.

@AxeNet : en se plaçant dans l’optique boulot, il n’y a pas grand chose à changer. Nous continuons d’évoluer sur les bases entreprises depuis quelques temps (SMO). Par contre, je n’ai jamais stoppé de dénicher les failles, ne serais-ce que pour les dénoncer (voir actions DarkSEOTeam). « Faire le mal pour faire le bien »

@Rudy : le mouvement était déjà bien lancé; ceci va simplement l’affirmer et l’accélérer encore plus. Tu es au coeur de la bonne synergie.

@Aurélien : huhu 😀 Comme j’ai dit à Mathieu, il n’est pas concevable de faire table rase de l’existant. Google ne peut pas chambouler son algo comme ça. Sinon, nous serions déjà en plein sémantique appliquée. N’oublie pas que ça fait déjà des années qu’ils bossent sur toutes ces notions et on n’en voit pas le moindre pet foireux apparaître sur les résultats de recherche.

Il faut voir ça comme un atout supplémentaire plutôt qu’un chamboulement.

Si si mon but est un peu de chasser un mythe par un autre, mais contrairement au SecureRank, je base mes propos sur du concret.

En discutant avec Bill Slawski, il apparaît que d’autres brevets laissent entendre que Google se permet de tracker également les utilisateurs qui ne sont pas loggués sur un outil ou service Google. Certains auront noté la présence de plus en plus régulière d’un tracking des liens sur les résultats de recherche. Par contre, je n’ai pas regardé du côté des cookies si Google se permet d’en poser un seulement si j’utilise son moteur sans être utilisateur enregistré d’une manière ou d’une autre. Pour cela, il me faudrait trouver un ordinateur et IP vierges.

On est bien d’accord là-desssus, je ne les vois pas changer tout, c’est inconcevable.

Pour tracer les visiteurs, ils ont plusieurs méthodes :

– cookie,

– IP

– et surtout cookie « flash » et ceux-là, il faut le vouloir pour s’en débarrasser… Une simple visite sur un site ayant de l’adsense, et c’est grillé !

Ils peuvent faire un peu ce qu’ils veulent ensuite…

Ping : Bloguer ou ne pas bloguer » Fritz, Grib et les minettes

@ Mathieu : rien qu’en installant Google Chrome pour Mac, j’ai failli avoir une crise cardiaque quand j’ai vu Little Snitch (pare feu de connexions sortantes) qui sonnait l’alerte rouge. Il y a un certain id.google.com qui n’est certainement pas là pour préserver ta confidentialité.

😆

J’utilise aussi LittleSnitch (que je trouve excellent), c’est grillé tout de même le dns 😀

Mouais, j’ai hâte de voir tout ça dans le futur.

Le Person Rank, ca se rapproche un peu des Clients parameters dont je parle dans un de mes articles ca!!

Non mais certains parametres utilises dans le classsement Google utilise deja nombre de paramtres… clients Bing aussi avait annonce il y a un moment qu’ils utilisaient des paramtres utilisateurs (via hotmail) pour un mielleur display des liens sponsorises … Ils avaient dit a l’epoque que ca ne touchait pas les resultats naturels

« Je ne crois pas que Google trafique manuellement les résultats de recherche. » Ben, je suis pas si sûr que toi. Mon site insertcasa.com est excellemment positionné en langue française pour des critères de recherche relatifs à l’immobilier en Espagne, dans les 10 premiers résultats parfois sur plusieurs millions de pages, et je nage lamentablement au fond du classement pour les versions en allemand et en anglais de ce même site. Alors que j’utilise pour ces deux dernières langues les mêmes astuces de référencement (et j’espère, la même qualité d’information, mais ce n’est pas à moi d’en juger) que pour le français.

La seule différence, c’est mon niveau de langue: le français est ma langue maternelle, et j’ai parlé couramment les deux autres, il y a… quarante ans. Je pense que cela se ressent dans mes rédactions, et je ne vois pas d’autre explication que l’intervention d’un humain qui aura décidé qu’en cas d’ex-aequo, en français je passe devant, et dans les autres langues, c’est un autre qui passe devant.

@jacques, votre problème ne vient pas d’une pénalité ou filtre manuel, mais du fait que le site est destiné principalement à un public francophone (hébergement en Suisse), et que les pages dans une autre langue son hébergé sur le même niveau.

Dans ce cas là, des sous-domaines avec Géo-ciblage dans GWT, ou sous-domaines + geo hébergement sont les seuls moyen de pouvoir être compétitif pour les requêtes étrangères.

ps. Utiliser une même page pour francais et allemand n’est pas non plus conseillé (les pages denia1.htm et pedr1.htm pour ne citer qu’elles.)

Pour Léo:

Ah ? bon ! merci beaucoup des conseils 🙂

Vraiment merci. Jacques.

@JAcques

J’ai un petit article sur le referencement International plutot bien fait sur mon site.

http://www.seo-muscle.com/international-seo-tips/

Je rejoins Leo pour dire que les classement ne sont pas uniquement dus au contenu. la popularite du site dans les differents pays cible elle aussi est importante (lien venant de sites heberges dans le pays cible)

J’ai une situation similaire avec ma page Black hattitude qui erst tres bien place ici aux US mais qui n’est pas dans le top 200 en france!

Merci aussi WEB CMS, ton papier complète harmonieusement les explications de Leo 🙂 Jacques.

Je pense que c’est une bonne chose que se soit maitenant l’utisateur de aprt ces recherche et ces visite à des sites qui soit au centre de cette évaluation. Bien sur Il faut se rendre contre que certain sites comme les sites porno ont bien plus de visiteurs que des sites traitant de sujet éducatif. Alors la question est vas t’on vers un classement des sites suivant non plus leur interet mais vers des sites qui attire les foules par leur vice et par l’argent.

C’est de la prise de chou pour que dalle votre truc.

Google vous nique de toute façon et y a rien que vous pourrez connaître de plus en analysant un brevet ou un autre.

Bonjour après lecture de cet article et les réactions de chacun j avoue être partagé.

D’un côté je trouve ça assez formidable qu un site soit mieu placé car perçu meilleur que les autres par une personne et ses commentaires. ça obligera à travailler sur le contenu et donc plus pour les visiteurs que les robots.

Ce qui me gêne, c’est comment GG va définir qu un visteur est plus fiable ,a plus de poids qu un autre.

Autre chose que GG nous fiche, c’est limite aussi mais à part supprimer son abonnement du net je vois pas trop comment y échapper. je pense qu un garde fou indépendant serait vraiment nécessaire

En utilisant un système de vote type sidewiki ou à l’image de tous les annuaires « lambda », les limites de la naturalité des votes seront bien vite atteintes. Qui vote dans un annuaire à part le webmaster qui veut faire grimper son site ?

En trackant les données personnelles des utilisateurs des différents services Google, le panel sera limité (même si conséquent) et tous les sites ne seront pas « jugés » sur un pied d’égalité à mon sens.

Je partage à 200% cette théorie,ou alors faudrait m’expliquer pourquoi je gagne quand je pose des liens d’affi sur les sites qui ne m’appartiennent pas alors que je les référence de la même facons que sur mes sites perso ! ^^

@dop : moi, sur mes pages référencées pour les annuaires 🙂

Trève de plaisanterie, j’ai l’impression en regardant de plus près la stratégie marketing qu’ils tournent autour du même terme en y ajoutant des fonctionalités.

Afin d’éviter d’appeler une amélioration PR.0.1, TR.0.8, ils changent de nom pour faire croire qu’il y a du nouveau dans l’air alors que c’est toujours la même technologie employée à laquelle les ingénieurs ont ajouté quelques trucs pour montrer qu’ils bossent dur sur le produit.

@ cabinet conseil que les termes se rejoingnent s entrecoupent parfois ok, mais que ce soit la même chose j ai un doute

Et si le Personrank servirait essentiellement à cibler davantage les Adwords ? N’oublions pas que le but PREMIER de Google c’est de faire tout pour que son modèle économique fonctionne et grandisse. Oui l’analyse des utilisateurs permettra d’améliorer la pertinence du moteur de recherche, mais elle permettra je pense à améliorer le ciblage des publicités. Plus Google arrivera à déterminer avec exactitude les utilisateurs du Web, plus les Adwords seront ciblées, plus ils auront de clients, plus ils augmenteront leur chiffre d’affaire. Google n’est pas dieu, mais juste malin et il sait très bien comment faire pour détourner les choses et les pensés.

très bon article

@référencement max je te conseille d’aller lire le dernier billet sur le blog Axe-Net 🙂

Ping : L'impact de Twitter sur les Blogs

Merci bien pour cet article. Je partage ton sentiment concernant le fichage que google fait des internautes.

Deux questions me viennent à l’esprit:

Quel poids pèsera le « personrank » vis à vis des autres facteurs influençant SEO?

Les blog seront ils les grands gagnant de cette nouvelle formule?

A bientot pour de nouvelles aventures 🙂

Greg

Le webmarketing au service des entreprises à Montpellier

@ leo je peut savoir pourquoi?

Je parlais de celui-ci : http://blog.axe-net.fr/comment-spammer-un-blog-dofollow/.

Tu auras beaucoup plus de chance de voir tes commentaires publiés quand tu décides d’en laisser sur des blogs dofollow 🙂

Je me permet de donner mon avis.

Il est possible que Google est effectivement abandonné le trust rank, concernant le dépôt de marque, mais pas dans son algo.

Nous savons que tous les géants dans un domaine donné envoient des leurres.

La formule exacte doit être protégée et pour rééquilibrer les positionnements et les recentrer, nous avons constaté depuis des années que des concepts et d’autres arrivaient vite remplacés eux-même.

Si un lien d’un site A vers un site B est un vote, encore aujourd’hui, comment google peut-il juger de la pertinence de ce lien??? Je pense que Google s’appuie sur une « chaîne de commandement » et de « renseignement ».

Si cela peut apporter ma contribution et mon avis.

Salutations,

Stefano.

Il semble évident que la notion de trust rank semble bien réelle. Trust rank ou quel que soit son appellation, nous avons tous constaté que lier un site depuis certains sites considérés d’autorité (je ne parle pas de page rank mais de popularité, de confiance et sites à trafic) avait une incidence différente que de le lier à un site à fort page rank créé purement artificiellement (sites de même réseau ou autre). Le choix d’un bon lien est soumis à de multiples facteurs dont certains que nous ne maitrisons pas.

c’est la première fois que j’entends parler du person rank mais je pense en effet que c’est la direction que prend google avec tous ces outils qui permettent d’enregistrer ce qu’on fait sur internet…

Bonjour à tous,

Pour réagir sur ce post et apporter ma vision des choses et bien au-delà du phénomène des links et backlinks, comme certains d’entre vous, je reste septique sur un abandon du TrustRank, serait-ce un buzz de Google pour valoriser une fois de plus un de ses termes phares ?

A mon humble avis, bien souvent Google se démarque sur internet par l’apparition de nouvelles terminologies liées aux technologies web et au webmarketing. Ne trouvez-vous pas étrange cette fascinante suite des chose : PageRank, TrustRank, PersonRank…PhenomèneRank?

Affaire à suivre.

Bonne continuation à tous.

Doughi

Google ne cesse de changer les règles,ca m’étonne pas que le trustrank sera abandonné pour faire place à un notre système.

il faudra s’adapter mais surtout bien anticiper.

@conseils site web comment veut tu anticiper ce qui n’existe pas?

Quand je dis « anticiper » c’est de s’informer comme c’est le cas de cette article.

Je veux bien qu’on ne lise que les informations importantes dans un article, mais… 29 février 2009 ?

C’était fait exprès ?

La légende urbaine du TrustRank semble bien établie au sein de la communauté du référencement et au-delà.

Merci bien pour cet article.

Il y a que google qui sait ou il nous pousse dans l’avenir du référencement.

Vraiment heureux de poster mon commentaire sur ton blog. Je suis heureux que vous partagiez cette info utile avec nous.Merci!

De toute façon se sera toujours google qui donnera le ton pour nous dire comment il veut qu’on référence un site.

Du moins tant qu’il aura le monopole de sa grandeur de cannibale du web.

On sait jamais dans l’avenir peut être qu’un moteur va enfin ce réveiller et lui prendre un peu de sa supériorité pour lui faire enfin un peu concurrence.

Cet article a presque 1 an et on peut donc dire que le PersonRank est mort-né non ? Nul nouveauRank à l’horizon, c’est trop calme ne trouvez-vous pas ?

Le pagerank n’est pas prés de mourir ça reste à se jour la seul façon d’évaluer un site. Je reconnais que le pagerank n’est pas la meilleur solution mais en l’absence d’autre système de mesure ont fait avec. Personnellement mes clients recherche des liens dans du contenue textuel pour leur site en page index sur des gros pagerank, je ne fait que utilisé l’unité de mesure que Google à crée, pas facile de tuer ça création pour Google.

Le netlinking à encore de beau jour devant lui et la vente de de lien textuel n’est pas prés de se terminé de sitôt.

Notre copine Google n’est pas prête d’abandonner le système de popularité, c’est au coeur de sa démarche marketing.

en ne présentant que des sites que les internautes aiment, par un lien de cause à effet, les internautes aimeront Google…après, dans la forme il peut changer…

I haven’t really figured out TrustRank yet, but that’s due to all the mysterious environment Google made on it. But sounds interesting doesn’t it. I really think it does. Different idea again by the google guys.

Alors ce match de tennis TrustRank / PersonRank ?

Lady Gaga ? J’en suis Gaga !

Ping : La manipulation manuelle est possible sur Google

Ping : Conférence sur le PersonRank au SEO Campus

Google, Bing, et Yahoo continue le Page Rank. C’est encore vivant!

Google, Bing, et Yahoo continue le Page Rank. C’est encore vivant!

qu’en est-il en 2011 ?

@ ccda

on lis tellement d’information contradictoire à ce sujet, qu’on s’est plus quoi penser.

Notre copine Google n’est pas prête d’abandonner le système de popularité, c’est au coeur de sa démarche marketing.

en ne présentant que des sites que les internautes aiment, par un lien de cause à effet, les internautes aimeront Google…après, dans la forme il peut changer…

Bien sur, le Page rank est toujours d’actualité la prochaine google dance est à venir .

David

Tout ça n’est plus important et le sera encore moins dans le temps.

Cet article intéressant nous fait réfléchir quant à la suprématie et l’omniprésence de google. Google est partout !!

Salut Laurent, de l’eau a coulé sous les ponts entre déjà l’écriture de cet article mais aussi depuis la notion de pagerank, trustrank à personrank. Tous ses outils qui permettent à Google au mieux de gérer ses serp prêtent à confusion. Je me permets de te poser ces deux petites questions au delà du nouveau filtre mis en place par la firme à savoir Google Panda 2.5 : « Sur quelle type de rankmachin faut-il établir sa stratégie SEO ? Y a t-il une ressource pour suivre les instructions ? Merci

Google donne toujours le Page rank comme toute les années. C’est qu’il a toujours une utilité pour lui. On a beau dire qu’il est mort depuis longtemps mais il est toujours la. La seule chose c’est que google se sert d’autre baromètre pour apprécier un site ou non comme le +1. Le page rank est toujours a l’heure actuelle une chose que tout le monde se sert pour le partenariat.

Je me demande dans l’algorithme entre deux pages aux contenus identiques si une page avec quelques liens d’autorités se positionnerait mieux qu’une page sans liens mais likée, retweetée, plussée avec des comptes « influents ».

Je pense que le PageRank est toujours un facteur très fort … excusez mon français, je suis britannique

De source sûre, le Page Rank est obsolète.

Si on se place du côté de l’annonceur, le PersonRank est une belle façon de toucher sa cible.

Par contre de mon point de vue d’utilisateur, je ne suis pas sûr de la valeur ajoutée.

Par ailleurs, la personnalisation des résultats en fonction -entre autres- des habitudes de navigation n’irait elle pas à l’encontre du business model de Google avec ses liens sponsorisés ?

Autrement dit, si je ressors mieux sur mes mots clés génériques en organique, pourquoi investir plus en SEM ?